Nem tudjuk kulcsra zárni a mesterséges intelligenciát, de a valóságot megpróbálhatjuk

Múlt héten bemutatkozott Navracsics Tibor digitális klónja, amely kínaiul és hollandul kezdett magyarázni a Facebookon. Első mondatában magyarul figyelmeztetett, hogy a klón nem ő maga, mármint a közigazgatási és területfejlesztési miniszter. De enélkül vajon hányan dőlnének be egy Navracsics-klónnak, ha például arról beszélne – magyarul –, hogy hazahozta az EU-s pénzeket?

A mesterséges intelligencia (MI) által generált tartalmak felismerhetőségében jelenleg átmeneti korszakot élünk, de ez várhatóan nem fog sokáig tartani. Egy kutatás eredményei szerint valós emberi arcokat már 2022-ben sem tudtak a résztvevők megkülönböztetni MI generálta arcoktól, és a legtöbb ember nem igazán tud különbséget tenni egy ember és a GPT-4.5 vagy a LLaMa által generált szöveg között (előbbi az OpenAI, utóbbi a Facebook nagy nyelvi modelje). Ugyanakkor még látunk hatujjú embereket MI-képeken, és ha jobban megnézzük, Navracsics klónja is akadozik fejforgatás közben. Ezekről viszonylag könnyen megmondható, hogy nem valódi képeket, videókat látunk.

A legvalószínűbb forgatókönyv, hogy az MI rátanul az emberi anatómiára és más határterületekre. Eltűnnek a túl sok ujjú kezek, és pár éven belül azok sem tudnak majd különbséget tenni mesterséges és valódi képek, videók között, akik ma még talán igen.

A közös valóság védelme

Az MI-tartalmak felismerése kontextus- és minőségfüggő. Vannak nagyon egyértelműen rossz minőségűek, és vannak olyanok, amelyeket már most sem lehet megkülönböztetni a valóságtól. Egy tavalyi felmérésből az derül ki, hogy a kínai és az amerikai felhasználók nagyjából véletlenszerűen minősítenek egy képet, hangmintát vagy szöveget valódinak, illetve MI-generáltnak. Felük valódinak, míg a másik felük MI-generáltnak tartotta ugyanazt a képet. A német felhasználók – vélhetően az MI német nyelvi fejletlensége miatt – magasabb, durván 60 százalékos arányban azonosították be helyesen az MI-generált szövegeket és hanganyagokat. A képek felismerésénél ők sem teljesítettek jobban, mint kínai és amerikai társaik.

Mit tehetünk egy olyan MI-vel, amely mindenkit képes lesz megtéveszteni? A válasz egy része lehet, hogy

nem az MI-t korlátozzuk, hanem a valóságot próbáljuk elzárni az MI elöl.

Az ENSZ digitális technológiákért felelős ügynöksége és az ausztrál kiberbiztonsági központ tanulmánya szerint a valóságot bemutató multimédiás tartalmakra olyan tartalmi hitelesítő*

Ebben a forgatókönyvben meglenne az elméleti lehetősége annak, hogy az internet bizonyos területeit megtartsuk valósághűnek annak ellenére, hogy nem elhanyagolható részét valószínűleg MI által generált tartalom, deepfake videók és hangfájlok adják majd.

Erre utal az az eset, amikor tavaly januárban több ezer amerikai, New Hampshire-i szavazó kapott telefonhívást, amelyben mintha Joe Biden elnök arra kérte volna a demokratákat, hogy ne szavazzanak az állam előválasztásán. Valójában ez egy mesterséges intelligenciával készült hamis hangfelvétel (deepfake) volt. A deepfake készítője vallomása szerint fel akarta hívni a figyelmet arra, hogy az MI veszélyes a demokráciára. Hatmillió dollár büntetést kapott, de egyértelművé tette, hogy a deepfake technológia már ezreket képes félrevezetni.

Szabályozással rá lehet szorítani a tartalomdisztribútorokat és a közösségi média vállalatait, hogy vagy korlátozzák a hitelesítés nélküli tartalmakat, vagy minimum tegyék egyértelművé a felhasználó számára, hogy melyik videó autentikus és melyik nem az. Azaz hogy melyik videó készült egy valós telefon valós kamerájával és melyik az, amiről ez nem derül ki. Az optimista verzió szerint a társadalmi diskurzus olyan platformokra terelődne, ahol alapvetően megbízható forrásból származó anyagok érhetőek el.

Az egyén védelme

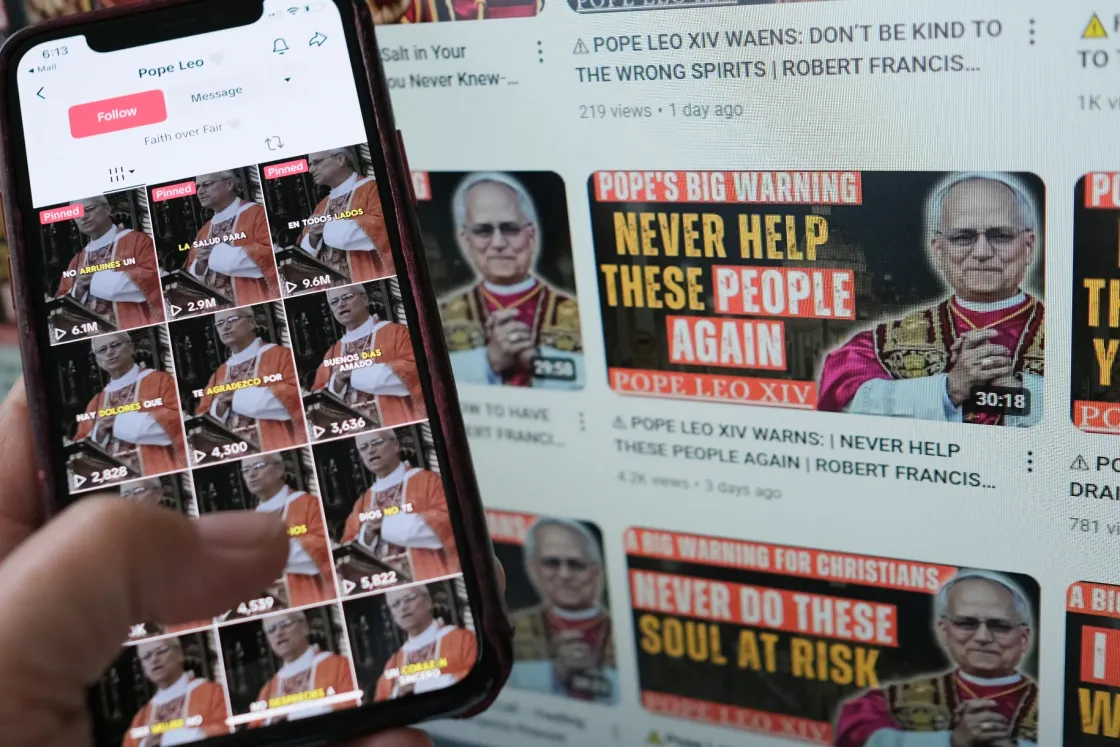

Ha sikerül is a közügyekkel foglalkozó területeket megvédeni az MI negatív hatásaitól és az MI-szennytől (angolul AI slop: értelmetlen generatív MI-tartalom, ilyen például az Italian Brainrot), a csalásokat visszaszorítani talán még nagyobb feladat. A legjellemzőbb csalási forma a Deloitte banki csalásokkal foglalkozó anyaga szerint, hogy a csalók az áldozatok családtagjainak, főnökeinek vagy híres embereknek adják ki magukat a generatív MI segítségével. Hamis videóval, kamu e-mailekkel csikarnak ki pénzt az áldozattól. A banki csalások összesen nagyjából 12 milliárd dollárt tettek ki 2023-ban, és ez az anyag szerint 40 milliárd dollárra növekedhet 2027-re.

Dánia hozta az első olyan törvényt az uniós országok közül, amely kifejezetten a deepfake multimédiás tartalmaktól próbálja védeni a lakosságot. De a hírességekről terjedő deepfake videók Magyarországon sem ismeretlenek. Terjedt kamu videó Schwab Richárdról, Merkely Béláról, Szikora Robertről, Antal Anitáról és Halász Juditról is. A károkozás mértékétől függően az ilyen netes csalás büntetése egytől tíz év börtönig is terjedhet, de az elkövetők szinte mindig ismeretlenek maradnak.

Az oktatásnak hatalmas szerepe lesz abban, hogy megóvja a társadalom MI-megtévesztésnek kitett tagjait.

Mivel az internet egyre inkább tele lesz MI-generált tartalommal, az egyénnek meg kell tanulnia navigálni.

Az oktatás egyik feladata lenne azoknak az elemzési eszközöknek az oktatása, amelyek segítenek elválasztani a kamut a valóságtól. A másik pedig bizonyos viselkedési minták oktatása, ahogyan a pénzügyi csalásokkal szemben például már elkezdődött a Kiberpajzs programmal és a hasonló kezdeményezésekkel.

Rengeteg elemzési eszközt fejlesztettek az MI-tartalmak felismerésére az elmúlt években. A winstonAI, a CopyLeaks, a Deepware Scanner és az Originality.ai olyan programok, amelyek digitális adatok mintázata és a készítés előzményei alapján próbálják megállapítani egy hanganyag vagy kép eredetét. Ezek használata azonban hozzáértést igényel és annak belátását, hogy az eredményeik valószínűségalapúak, azaz nem feltétlenül helyesek.

A felhasználóknak tisztában kell lenniük a biztonsággal és a valósággal társítható jelekkel. Az ilyen jelrendszerek hamarosan bonyolulttá válhatnak, amire a fiatalokat oktatnunk kéne, írta Sam Wineburg, a Stanford egyetem kutatója. Bizonyos nagy nyelvi modellek már maguktól is képesek megtéveszteni a felhasználókat.

Több kutatás szerint – más hazugságok mellett – együttérzésre, szánalomra játszó kijelentésekkel próbálják rávenni csetelés közben az embereket, hogy helyettük hitelesítsék a „nem vagyok robot” alkalmazásokat. Például látássérült embernek adják ki magukat, és képernyőmegosztással kérnek segítséget. Az ilyen hitelesítő alkalmazások jellemzően a kurzor mozgását elemzik, ezért robotként nehéz átmenni rajtuk.

A gépi internet (machine-web) világában, ahol a tartalmak nagy részét már nem emberek, hanem MI és szoftverrobotok uralják, meg kell tanulnunk, hogy mások helyett sosem pipálhatjuk ki a nem vagyok robot mezőt. És ez csak a töredéke lesz az elsajátítani szükséges, a saját biztonságunkat szolgáló tudásnak.